1. DeepSeek R1 服务器部署步骤

第一步:安装 ollama

在ollama官网https://ollama.com/download 根据你的操作系统选择并点击 Download 按钮下载,下载完成后执行文件并一路next完成ollama的安装。

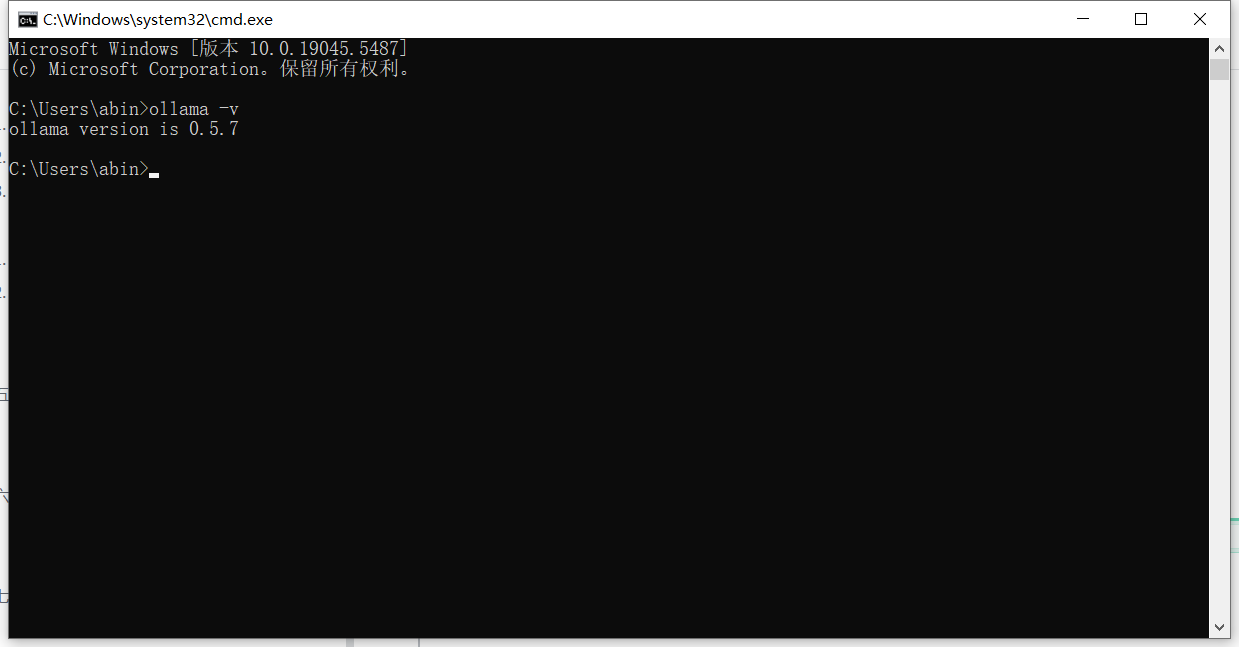

安装成功后,可以在任务栏看到ollama的羊驼图标,或直接在cmd命令行工具中输入ollama -v命令可以看到ollama 版本信息。

第二步:下载 deepseek 大模型文件

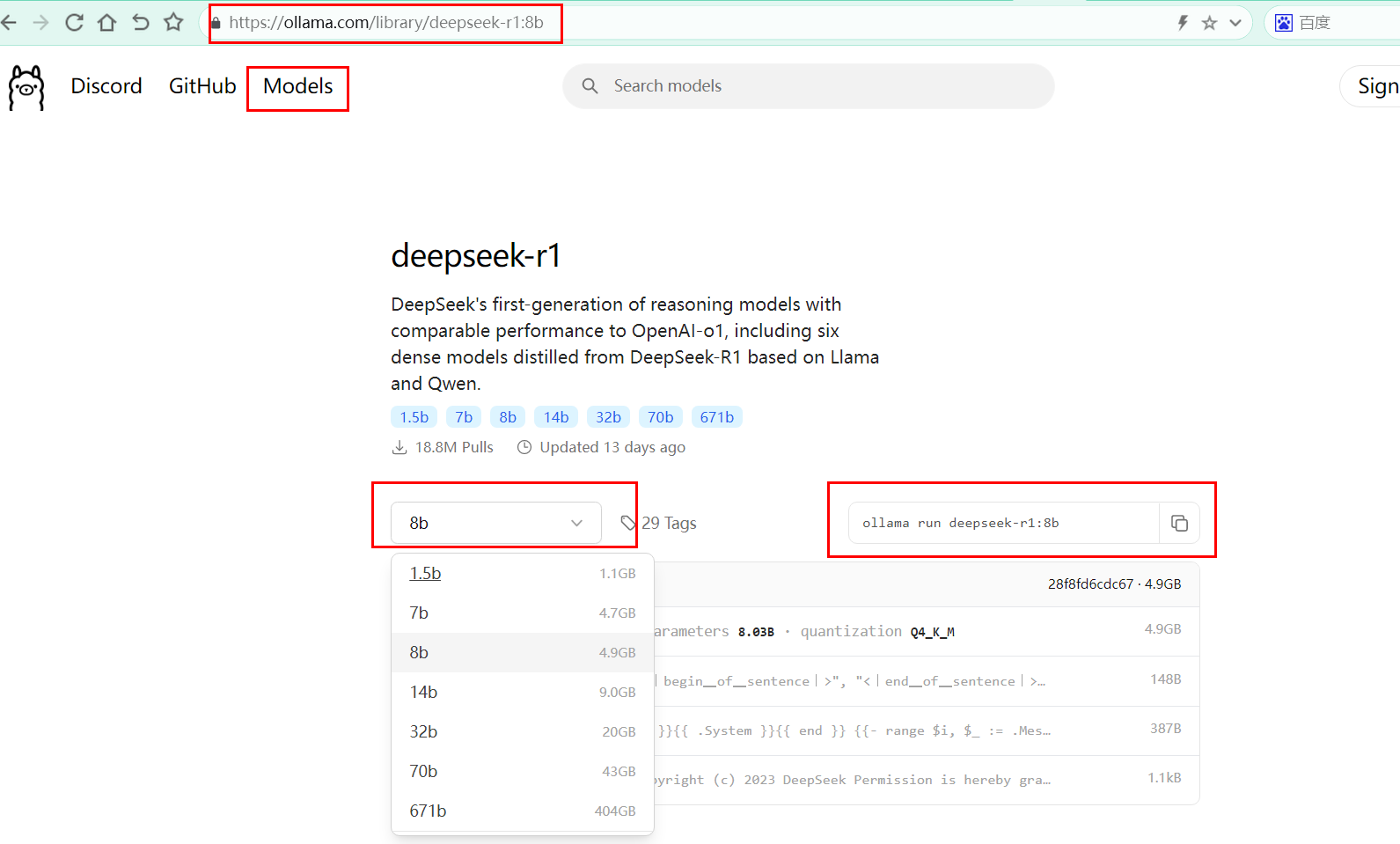

选择 deepseek,如果没看到,在搜索框搜索一下

第三步:选择合适的模型下载

文件越大、需要用到的本地资源就越多,相对来说,效果也越好。

企业部署推荐安装8b:ollama run deepseek-r1:14b

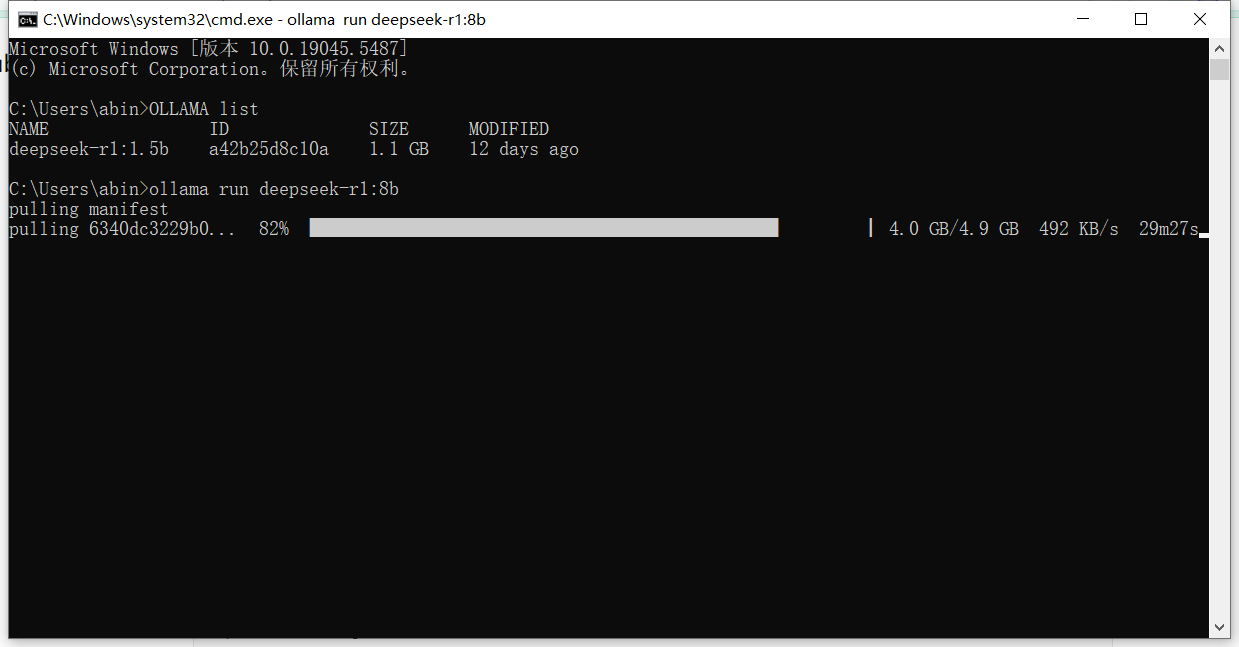

第四步:执行命令,启动并运行 deepseek-R1

ollama run deepseek-r1:14b

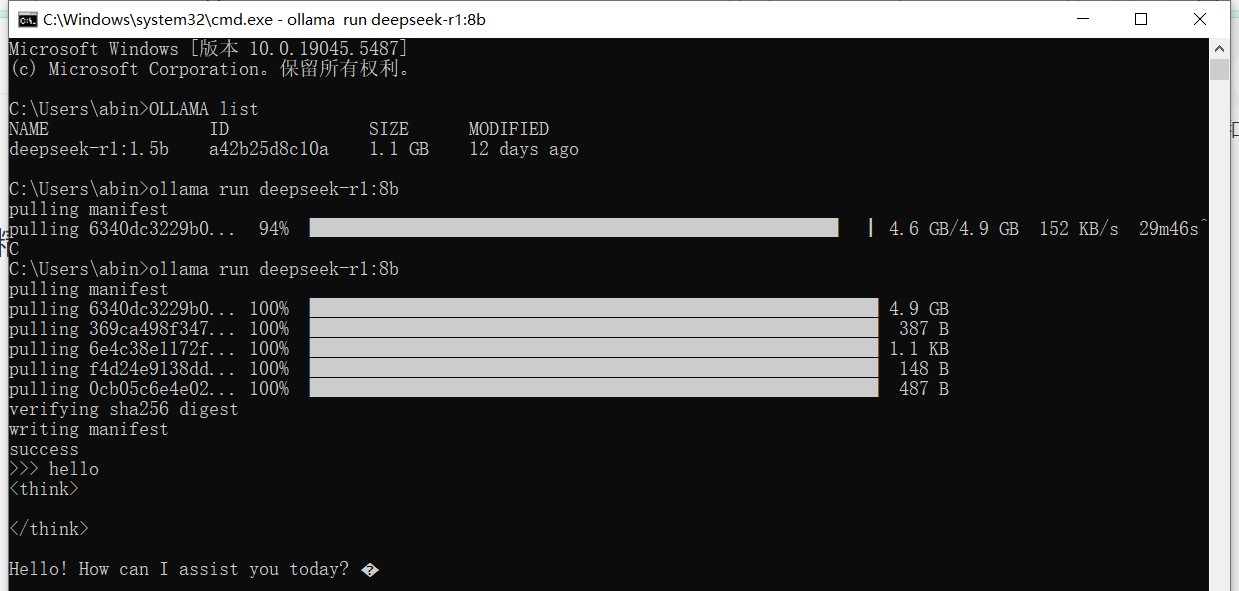

此图为安装8b示意图 第五步:启动成功

此图为运行8b示意图 参考文档

1. ollama官网:https://ollama.com/

2. deepseek官网:https://www.deepseek.com/

2. DeepSeek配置外网访问

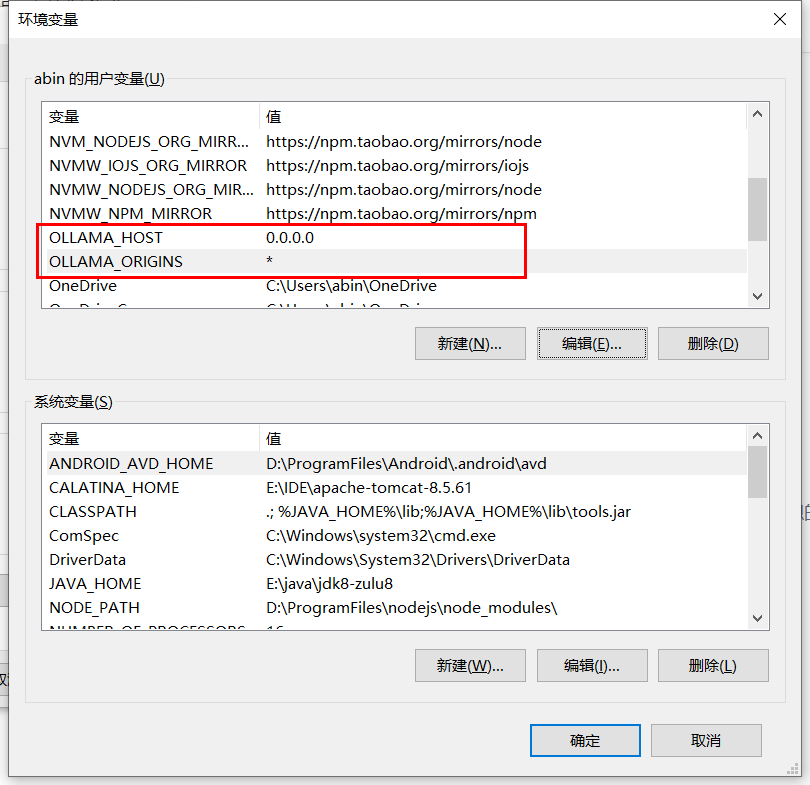

第一步:配置Ollama外网访问权限

在环境变量中新增OLLAMA_HOST=0.0.0.0和OLLAMA_ORIGINS=*两个参数,若需要修改默认端口,请添加OLLAMA_PORT=端口号,并配置你的服务器防火墙等,允许外网能访问服务器指定的端口,在服务器入网规则进行外网ip限定,以避免被外网其他用户访问,至此你的DeepSeek R1即可被你允许的外网进行访问,建立其企业内部的AI模型。

3. DeepSeek的安装位置迁移教程

DeepSeek在ollama平台下安装,默认会安装在C盘下,这会造成C盘体积庞大影响系统使用,所以我们希望能自定义DeepSeek安装位置。

首先请下在任务栏退出ollama:

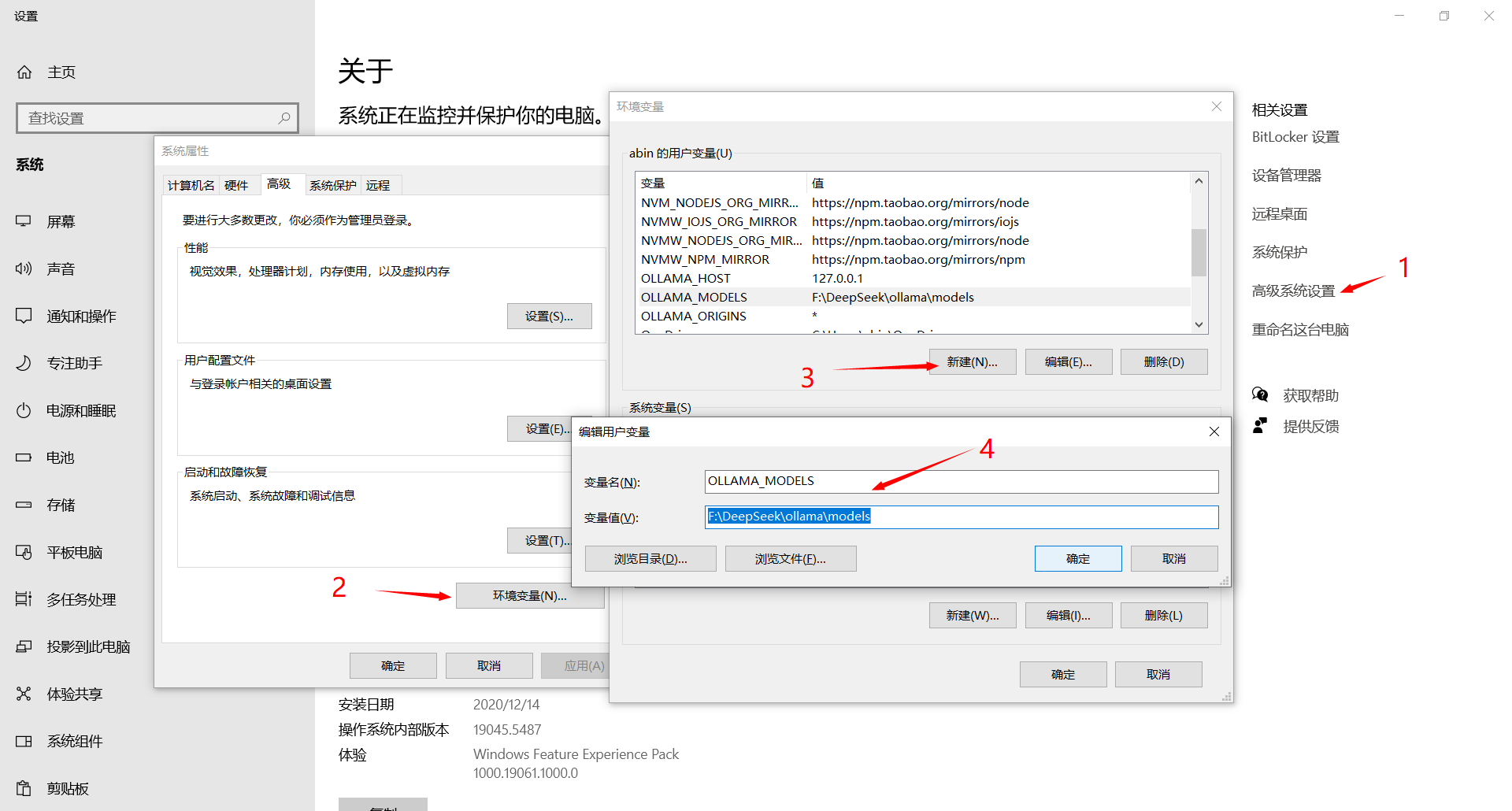

1. 配置ollama model环境变量

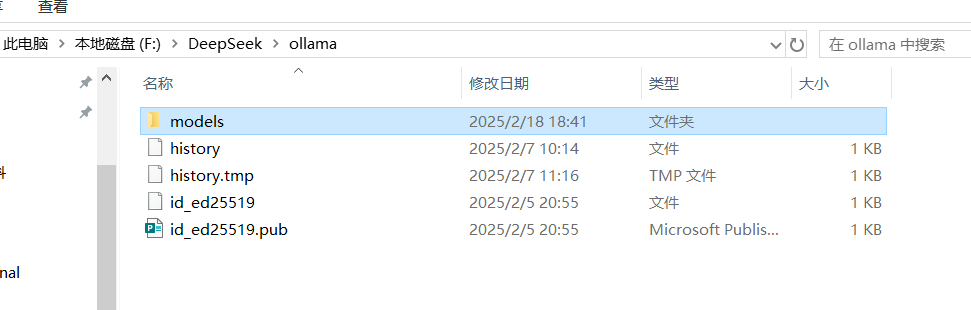

在我的电脑右键->属性,进入系统设置界面,按照下图步骤打开环境变量设置界面,在用户变量或系统变量下新增变量OLLAMA_MODELS,变量值设定为你希望将DeepSeek安装的目录下,如:F:\DeepSeek\ollama\models

2. 移动已安装的DeepSeek Model文件

一般ollama将的DeepSeek 模型安装在C:\Users\administrator\.ollama\models目录下,其中administrator根据你当前登陆操作系统的用户名而定,将models下的全部内容移动到步骤1配置的目录下

3. 重启ollama并进行DeepSeek迁移验证

在cmd命令行工具输入ollama list查看已安装的大语言模型,若能正常显示表示迁移成功,执行ollama run deepseek-r1:8b 运行r1模型,即可进行对话